Est-ce que vous avez déjà eu des problèmes bizarres avec l’export des CSV détaillés (i.e. problem_grade_report et pas grade_report) ? Il y a des 0 dans certaines colonnes qui semblent foireux. Selon moi une grande partie de ces 0 seraient des gens qui n’ont pas répondu à la question plutôt que des gens qui ont eu faux à la question.

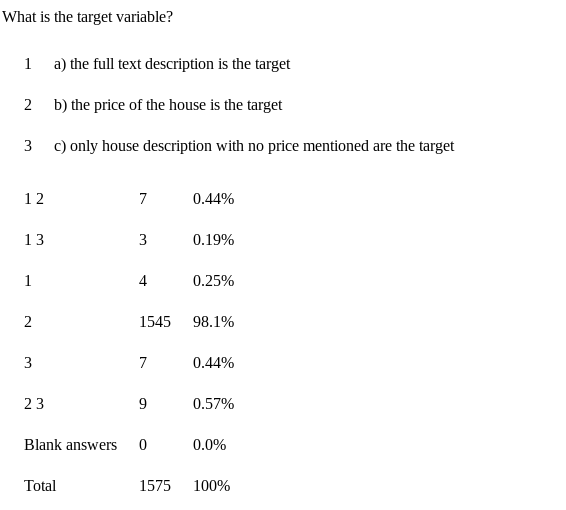

Un example détaillé : le Quiz Intro 01. question 3 a presque ~98% de bonnes réponses:

Live results accessibles à l’URL https://lms.fun-mooc.fr/courses/course-v1:inria+41026+session01/fun/dashboard/problem_stats/get_stats/56dd611fa528460888d315c1e8a86323

Si je regarde le CSV du 27/05

Et que je regarde la bonne colonne (avec pandas mais je vous laisse faire avec excel ou autre si vous préférez):

import pandas as pd

data = pd.read_csv(filename)

data['Quiz Intro 1: Introducing machine-learning concepts - Question 3 (Earned)'].value_counts(dropna=False)

NaN 6685

1.0 1319

0.0 736

Name: Quiz Intro 1: Introducing machine-learning concepts - Question 3 (Earned), dtype: int64

On a 1319 qui ont eu 1 point et 736 qui ont eu 0 point. Ça correspond pas du tout au pourcentage de 98% de bonne réponses (on serait plus à ~60%). Il y a un truc foireux, je me dis que parmi ceux qui ont 0 il y a des gens qui n’ont pas essayé le quiz … dans un monde idéal ceux qui n’ont pas essayé aurait NaN (ou N/A dans le fichier CSV) mais ça semble pas être toujours le cas.

Il ne semblerait pas que la colonne “Possible” aide:

# This is not related to the Possible column

data['Quiz Intro 1: Introducing machine-learning concepts - Question 3 (Possible)'].value_counts(dropna=False)

NaN 6685

1.0 2055

Name: Quiz Intro 1: Introducing machine-learning concepts - Question 3 (Possible), dtype: int64